Table of Contents

核心理念

代码工具可降低实现成本,但无法替代系统设计本身。

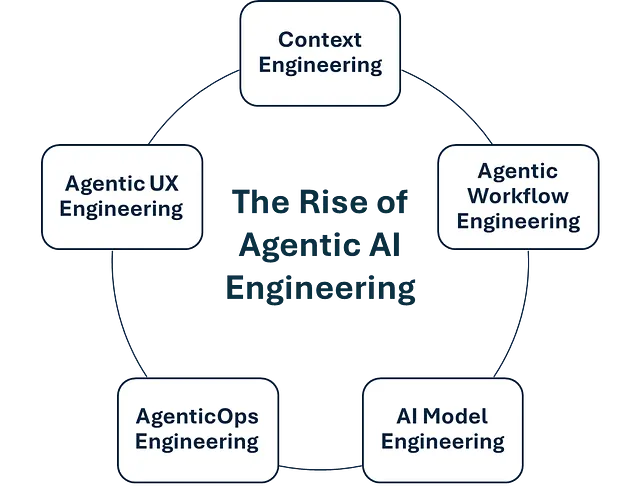

构建真正可用的智能体需系统性思维:Context Engineering、 Workflow Engineering、Model Engineering、 AgenticOps、Agentic UX

一、上下文工程(Context Engineering)

目标:为模型提供精准、精简的上下文,避免信息过载。

关键实践:

- 信息提纯

- 用摘要替代原始长文本。

- 结构化输出关键数据。

- 仅保留最相关上下文。

- 效果验证

- 通过上述优化,实际案例中幻觉率降低50%。

- 原则:上下文的核心不仅在于包含什么,更在于排除什么。

核心洞见:

智能体的能力不仅取决于模型本身,更取决于我们教会它关注什么。

二、工作流工程(Workflow Engineering)

目标:将复杂任务拆解为可控的多步流程,避免单次请求过载。

设计原则:

- 每步需具备:清晰目标 + 精准上下文 + 专用工具 + 明确交接机制。

- 循环工作流示例:

理解目标 → 澄清疑问 → 划分子任务 → 调用工具 → 评估结果 → 调整策略 → 生成输出

优势:

模型在小范围任务中表现卓越(推理与执行能力突出),但整体任务需分步协调完成。

三、模型工程(Model Engineering)

核心理念:不存在万能模型,需按任务类型分层选型。

模型分层策略:

| 模型类型 | 适用场景 | 代表模型 | 特点 |

|---|---|---|---|

| 推理模型 | 规划/决策/复杂合成任务 | GPT-4、Claude Opus、Gemini | 能力强、成本高、需慎用 |

| 非推理模型 | 分类/提取/格式化/摘要等任务 | Mistral等轻量模型/精调专用模型 | 成本低、响应快、稳定性高 |

选型逻辑:

- 关键决策层 → 选用高性能推理模型

- 标准化执行层 → 选用轻量模型控制成本

- 特定小场景 ->微调自己的模型

四、智能体运维(AgenticOps)

核心能力:保障生产环境中的稳定性、安全性与可扩展性。

关键实践:

- 分步测试:对工作流每步单独评估(而非仅验证最终结果),定位性能瓶颈。

- 持续优化:监控幻觉率、响应延迟、成本指标。

- 安全防护:输入过滤、输出审核、防滥用机制。

五、智能体体验设计(Agentic UX)

设计目标:建立用户对AI行为的信任感与可控感。

核心要素:

- 透明度:实时展示智能体决策逻辑与执行步骤。

- 可控性:允许用户干预关键决策节点(如确认/终止操作)。

- 协作感:设计「人-AI」协同界面,而非黑盒自动化。

总结:智能体工程的系统性价值

- 降幻觉 → 上下文工程 + 工作流分步控制

- 提效率 → 模型分层协同 + 轻量模型规模化

- 保稳定 → AgenticOps全链路监控

- 建信任 → 透明可解释的UX设计

终极洞见:成功的智能体是系统化工程的结果——教会模型聚焦关键信息,比单纯追求更大模型更重要。

参考: # Agentic AI Engineering: The Blueprint for Production-Grade AI Agents

请我喝杯咖啡

大家一起来讨论